镜像下载地址:https://mirrors.aliyun.com/ubuntu-releases/22.04.5/?spm=a2c6h.25603864.0.0.43804ddaHzKRyO

Ubuntu系统操作

安装ssh服务

root@yzn-virtual-machine:~# apt install ssh

查看状态

root@yzn-virtual-machine:~# systemctl status sshd

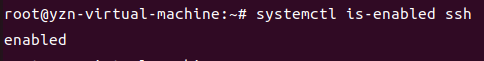

查询ssh服务是否自启动

root@yzn-virtual-machine:~# systemctl is-enabled ssh

安装ollama

ollama程序包云盘资源分享

视频中涉及到ollama程序包下载我上传到云盘中了,有需要可以下载

百度云盘:链接: https://pan.baidu.com/s/15kZYI7JKdOeQ9ME7Gl77sw 提取码: fy2p

夸克云盘:链接:https://pan.quark.cn/s/56271eb438af 提取码:e1pw

阿里云盘:链接:https://www.alipan.com/s/otCkXn1UUGy 提取码:j2n1(阿里云盘中ollama linux下程序是压缩包无法分享,只有windows下安装包)

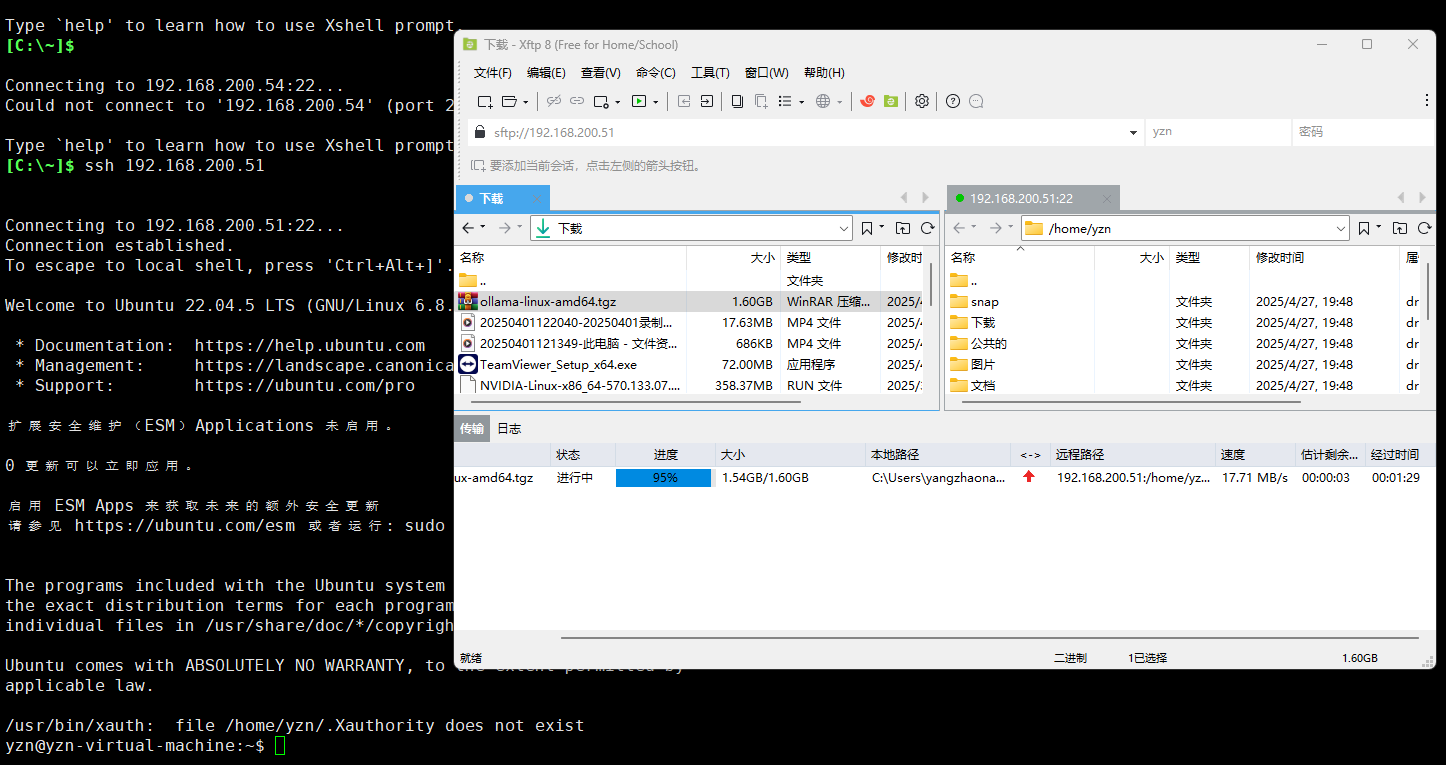

上传ollama包

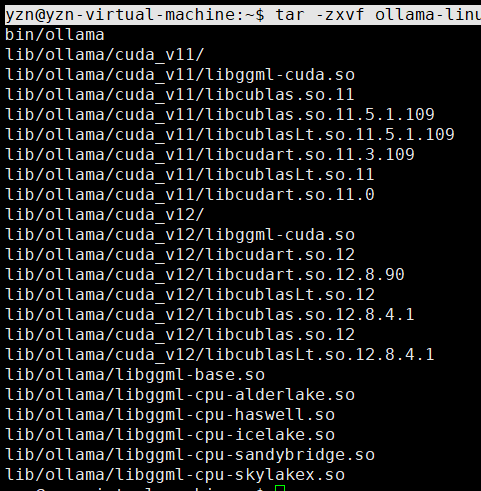

解压包

yzn@yzn-virtual-machine:~$ tar -zxvf ollama-linux-amd64.tgz

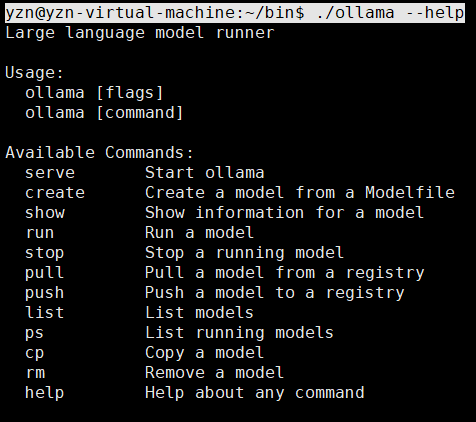

查看ollama命令参数

yzn@yzn-virtual-machine:~/bin$ ./ollama --help

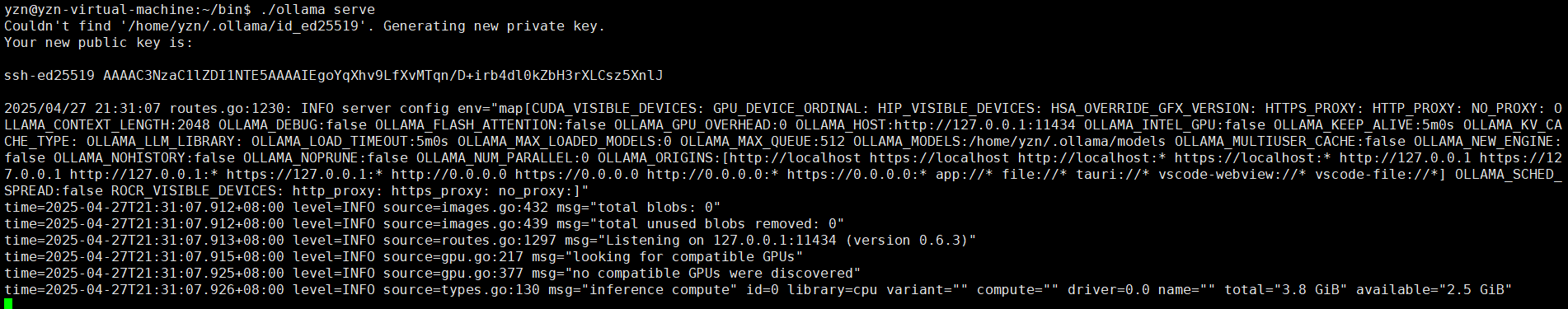

启动ollama

yzn@yzn-virtual-machine:~/bin$ ./ollama serve

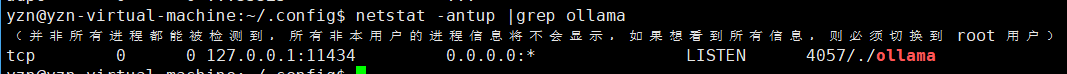

查看ollama端口

yzn@yzn-virtual-machine:~/.config$ netstat -antup |grep ollama

默认只能127.0.0.1本机连接,如何修改允许其它人连接

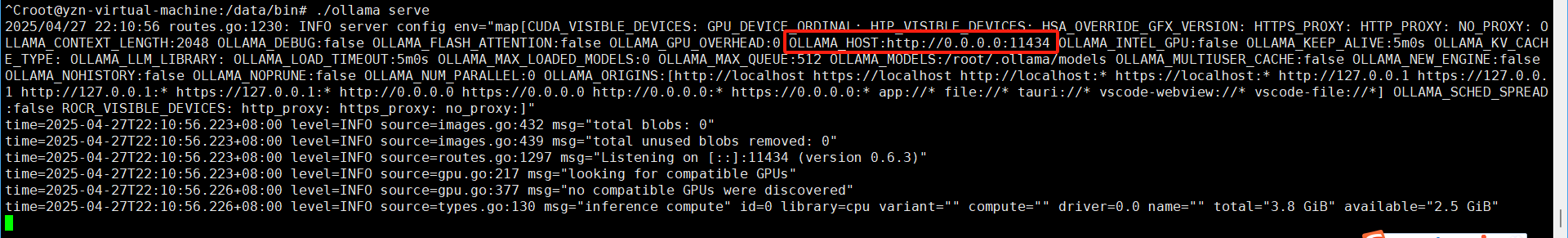

添加环境变量

root@yzn-virtual-machine:~# vi .bashrc

export OLLAMA_HOST=0.0.0.0

root@yzn-virtual-machine:~# source .bashrc

检测环境变量添加是否成功

root@yzn-virtual-machine:~# echo $OLLAMA_HOST

0.0.0.0

再次启动ollama

远程访问

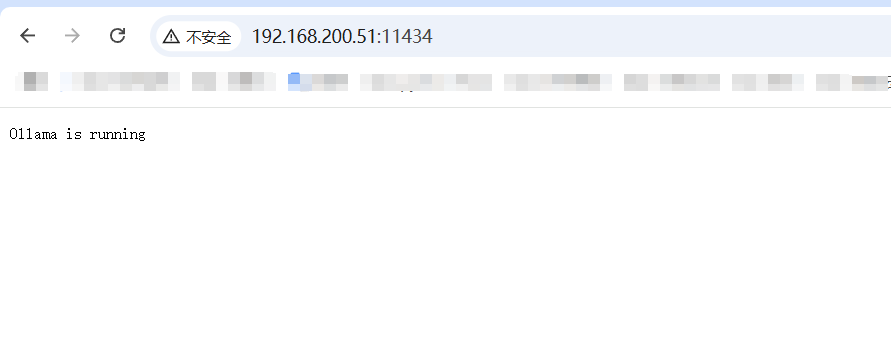

web浏览器访问下

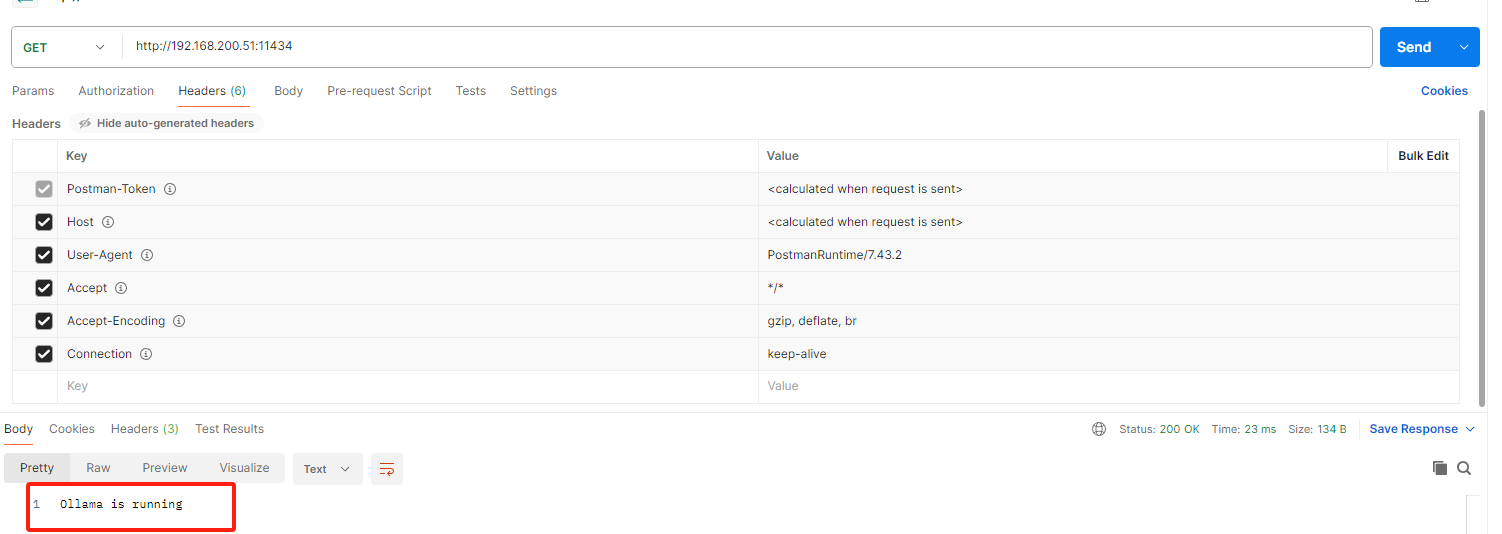

postman请求下试试

常用命令

命令行下载模型deepseek-r1

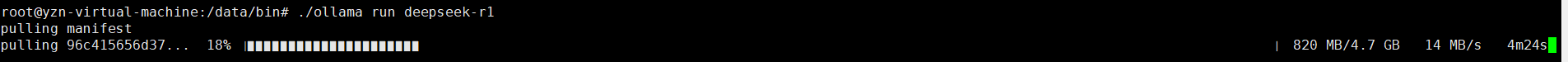

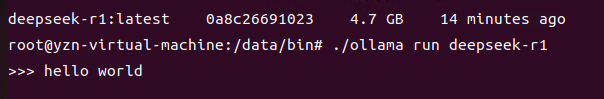

root@yzn-virtual-machine:/data/bin# ./ollama run deepseek-r1 (默认下载后自动加载)

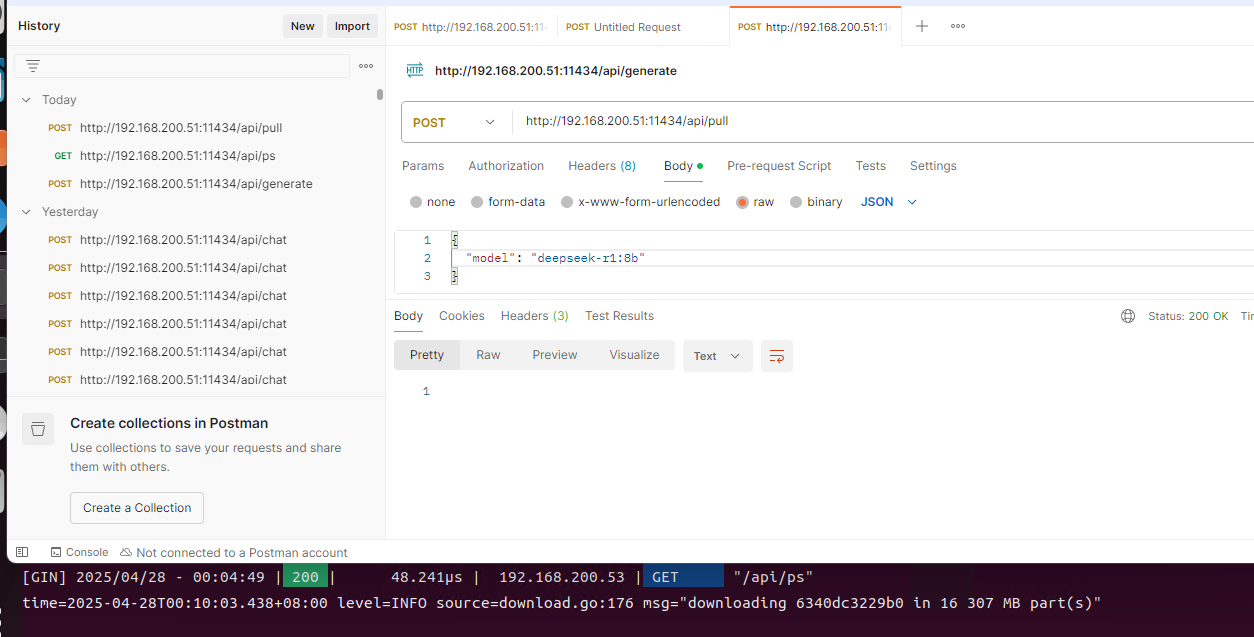

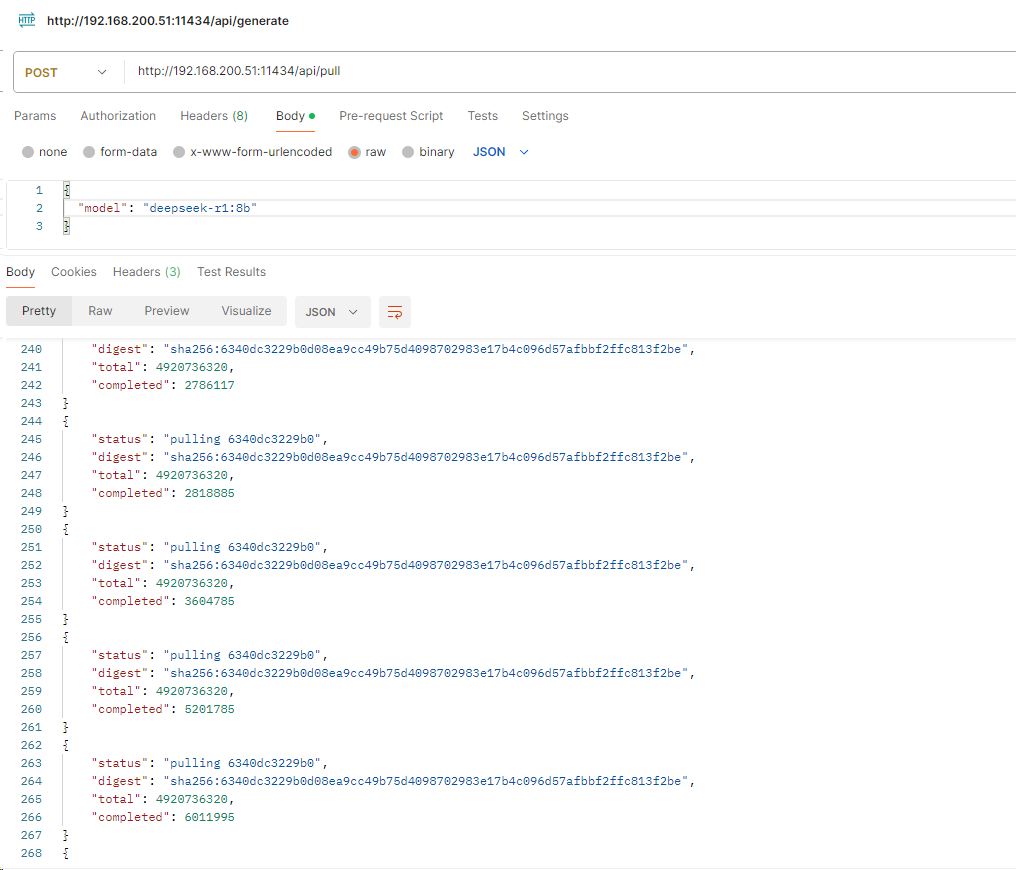

api下载模型deepseek-r1:8b

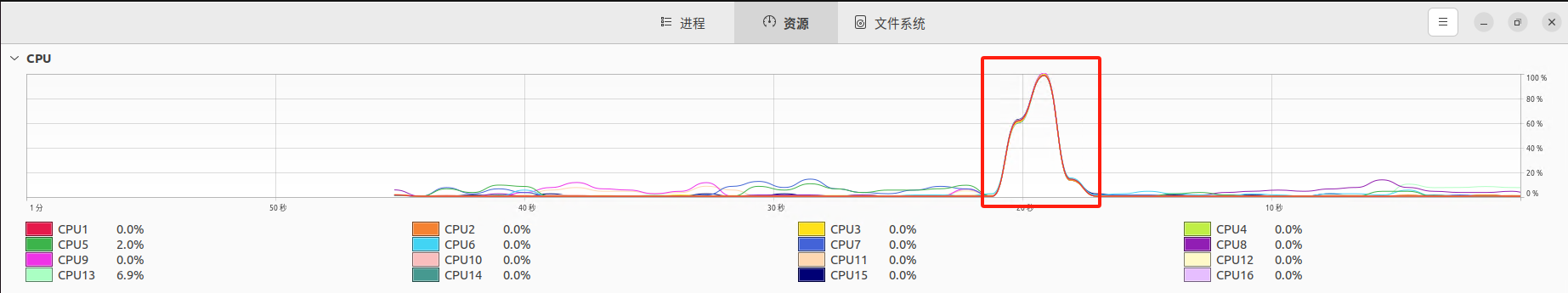

查看运行deepseek-r1模型服务器资源消耗

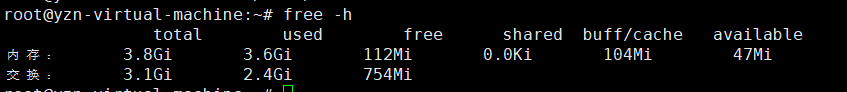

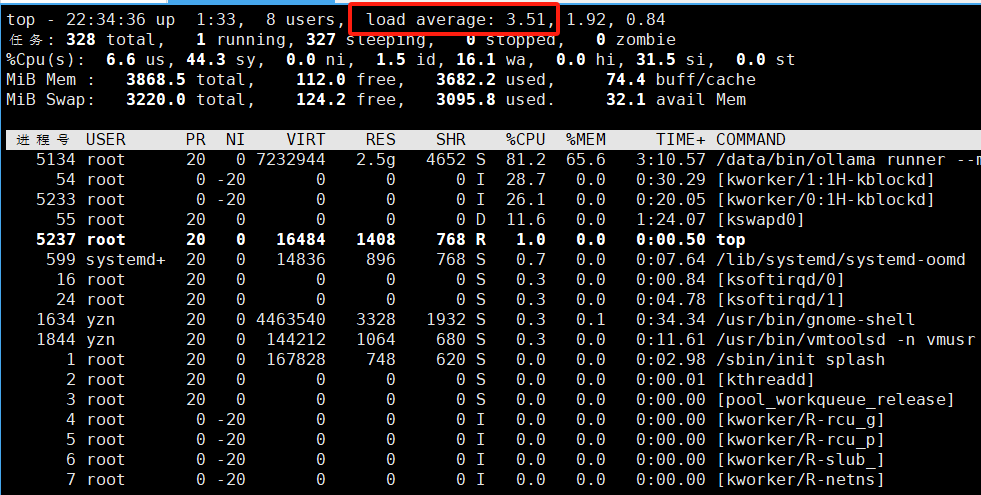

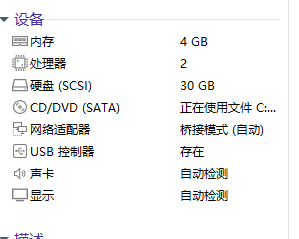

原来设置:4G内存4Gswap 实际内存:6G

原来设置:2核 实际使用cpu:3.5核

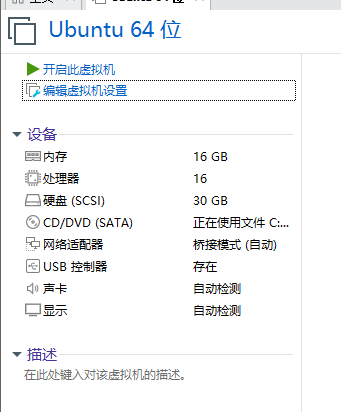

修改机器配置,改为8核16G再次测试

原配置

修改后

再次动ollama加载deepseek-r1模型查看资源消耗

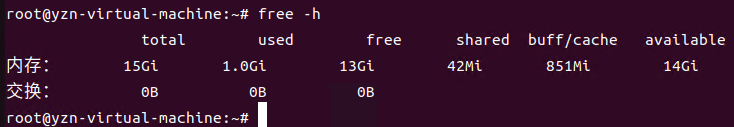

只启动ollama占用内存1G

加载ollama模型

root@yzn-virtual-machine:/data/bin# ./ollama run deepseek-r1

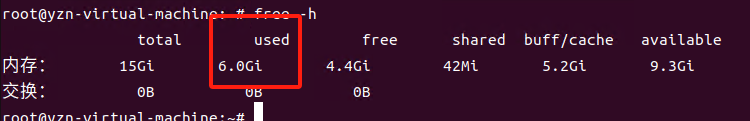

查看内存(使用6G):

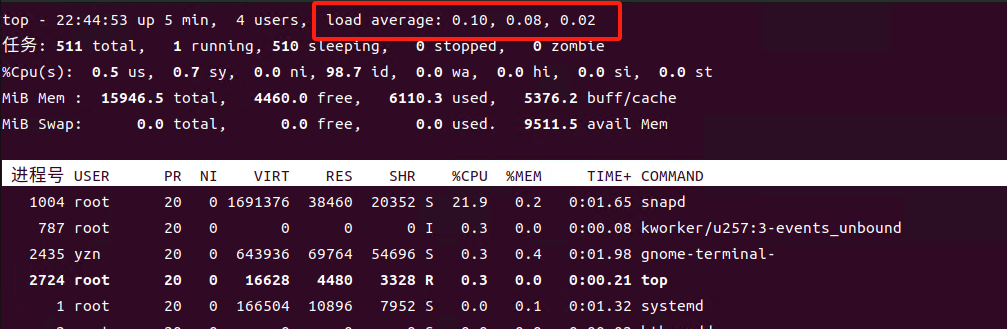

如果不调用模型发送消息cpu使用率很低,

我们发送个消息试试

再次查看cpu使用率

api调用下模型试试

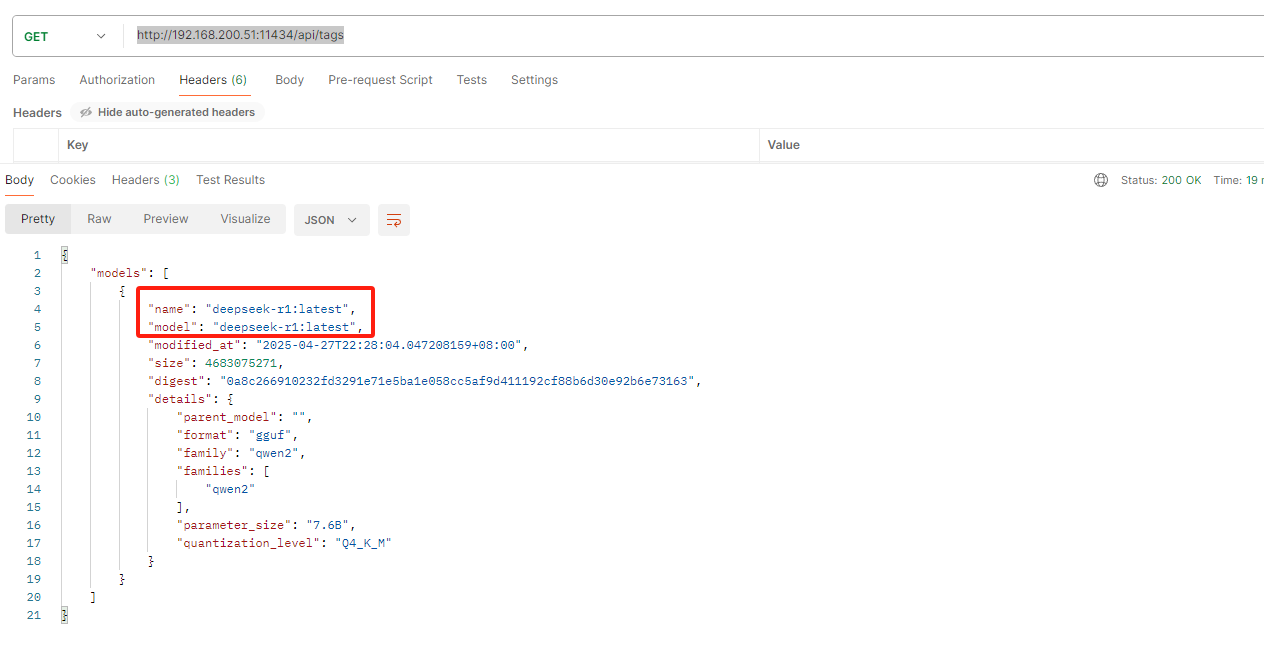

列出本地模型

http://192.168.200.51:11434/api/tags

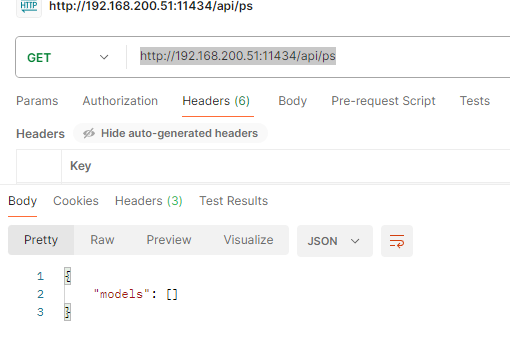

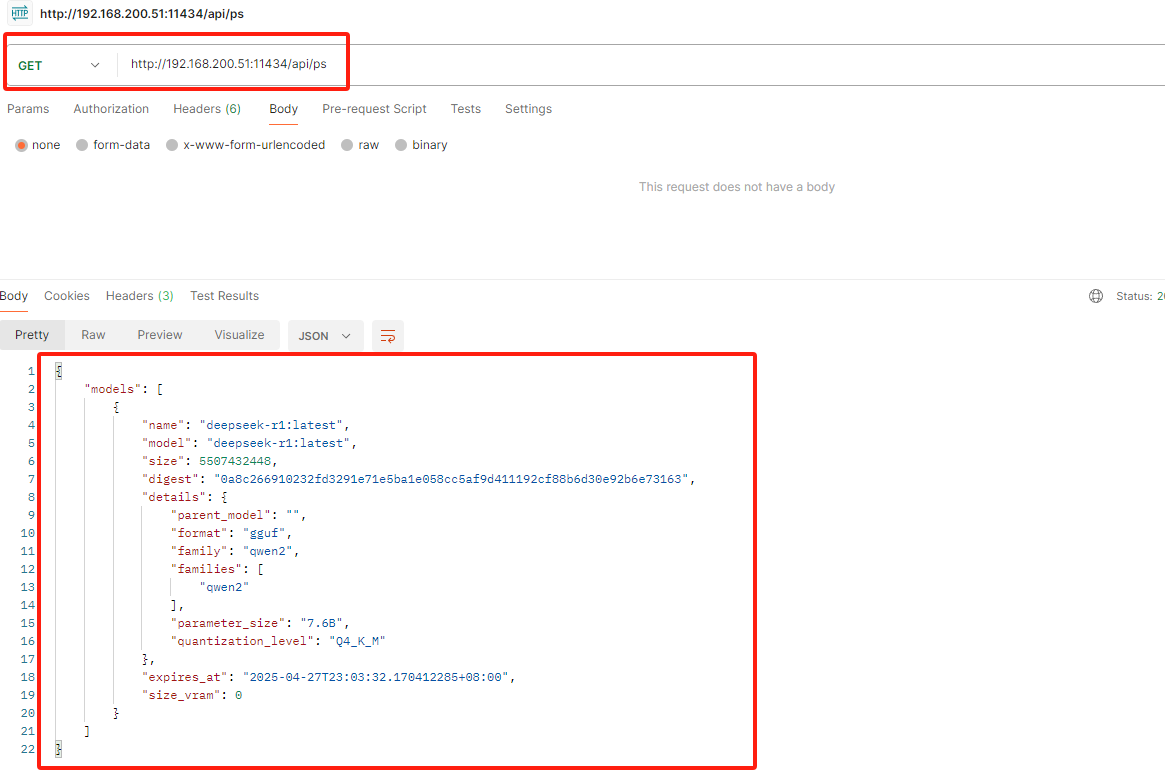

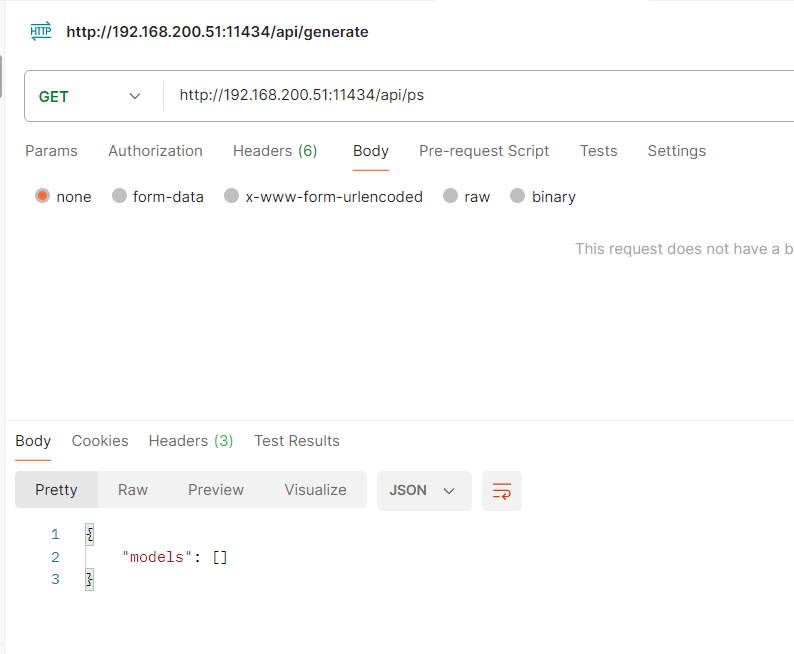

列出正在运行的模型

http://192.168.200.51:11434/api/ps

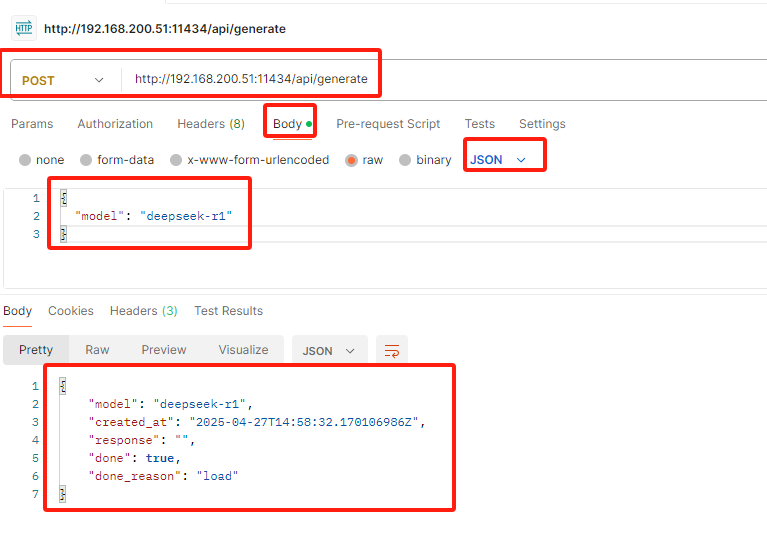

先加载模型

1、加载模型

2、再次查看正在加载模型

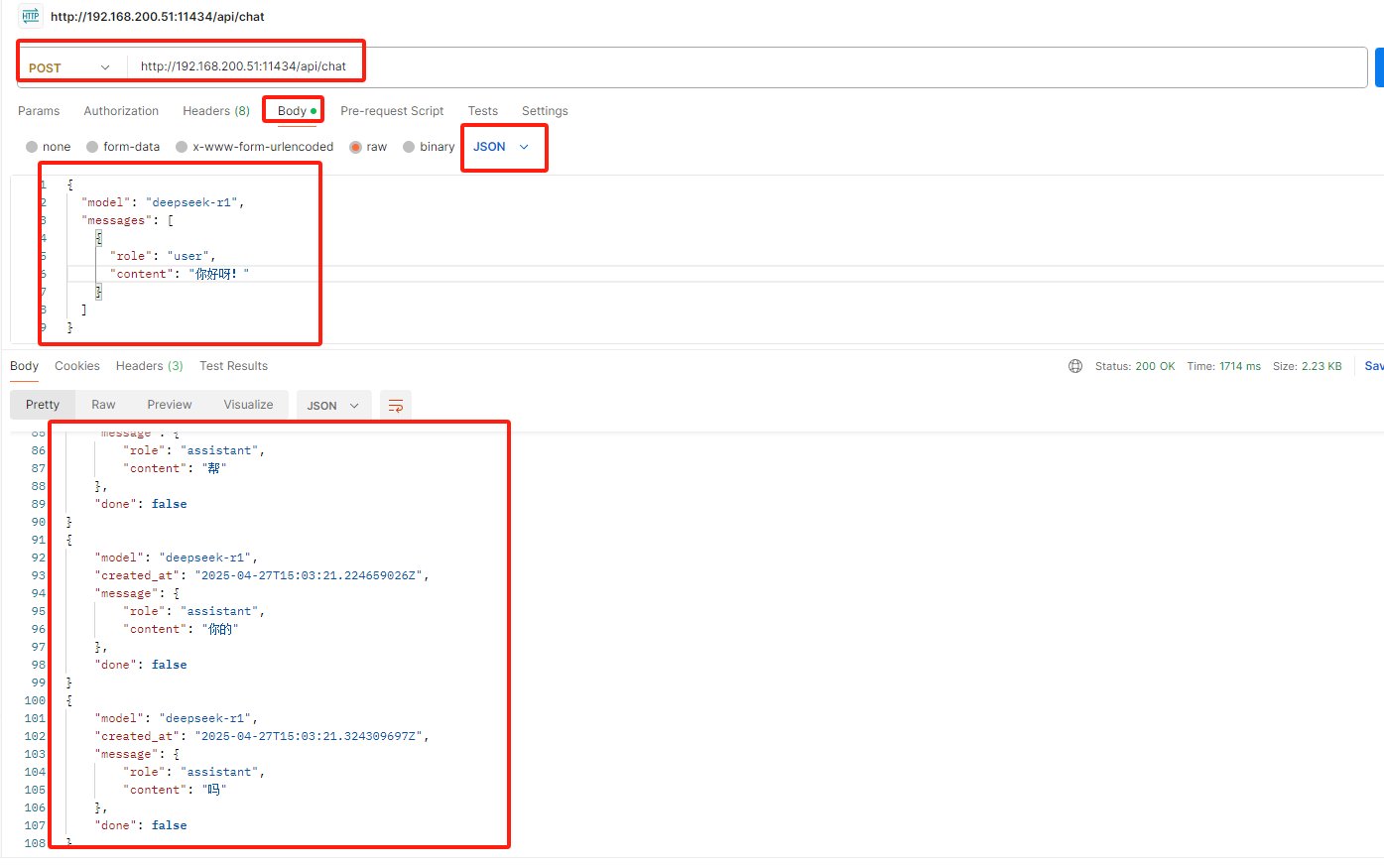

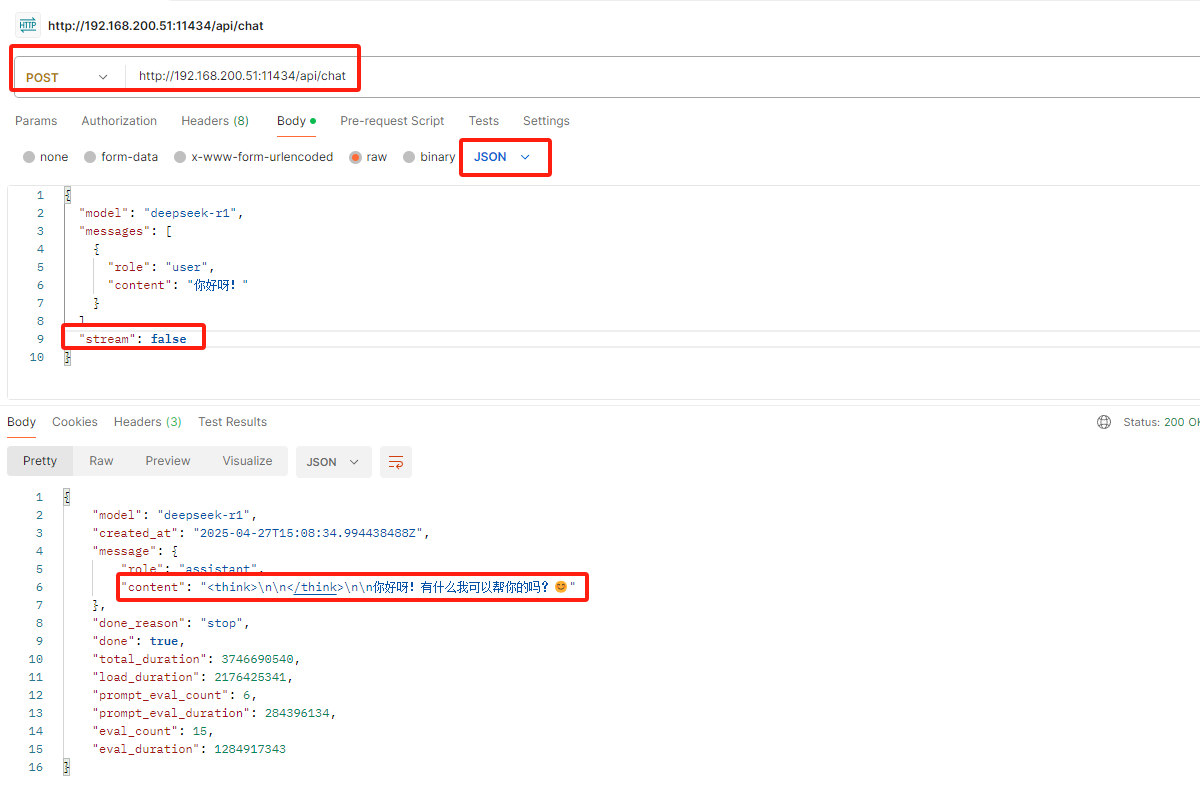

3、生成聊天(发送个消息)(JSON流媒体)

我们发现返回的信息是分为好几个字段的,能不能总结成一句话返回呢(无效流媒体)

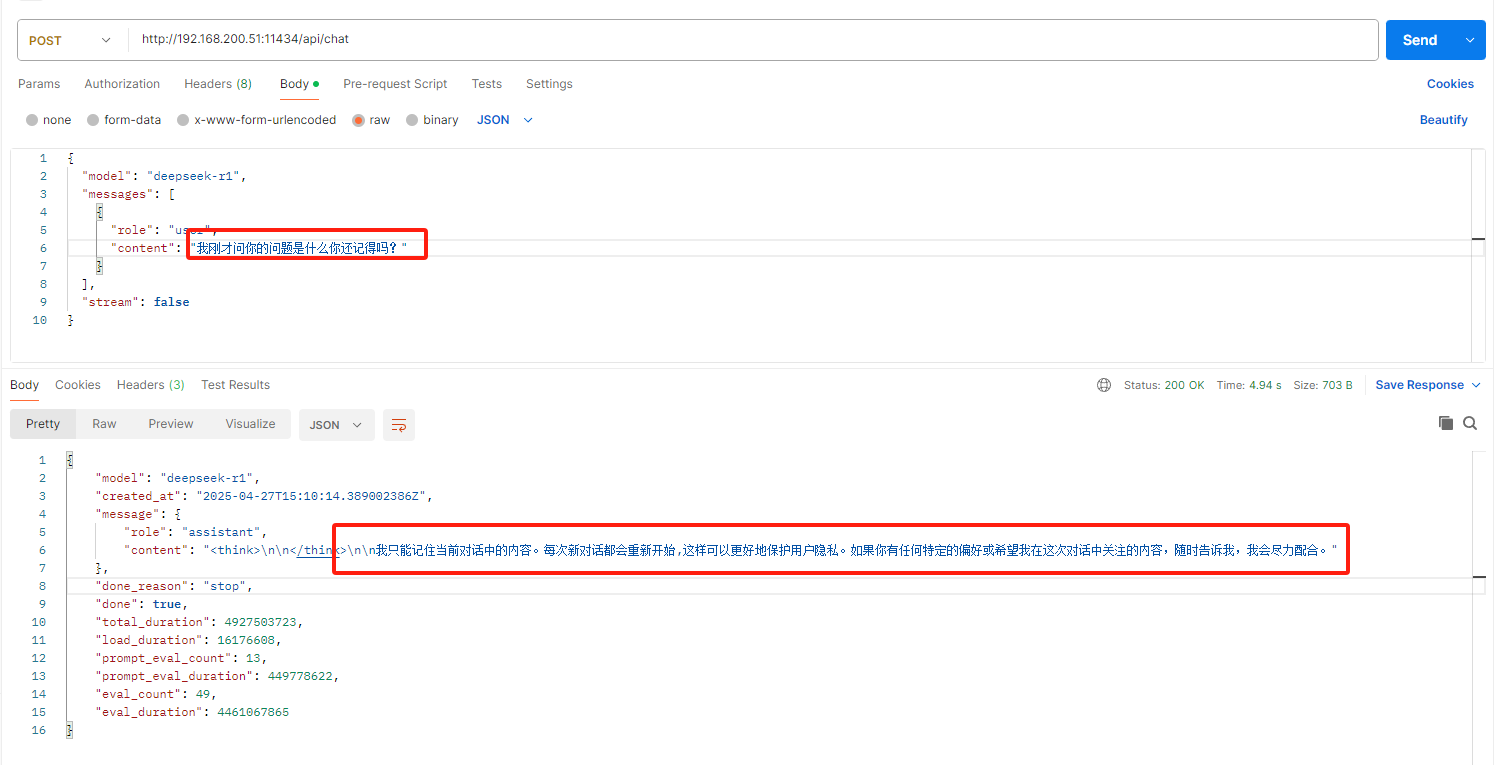

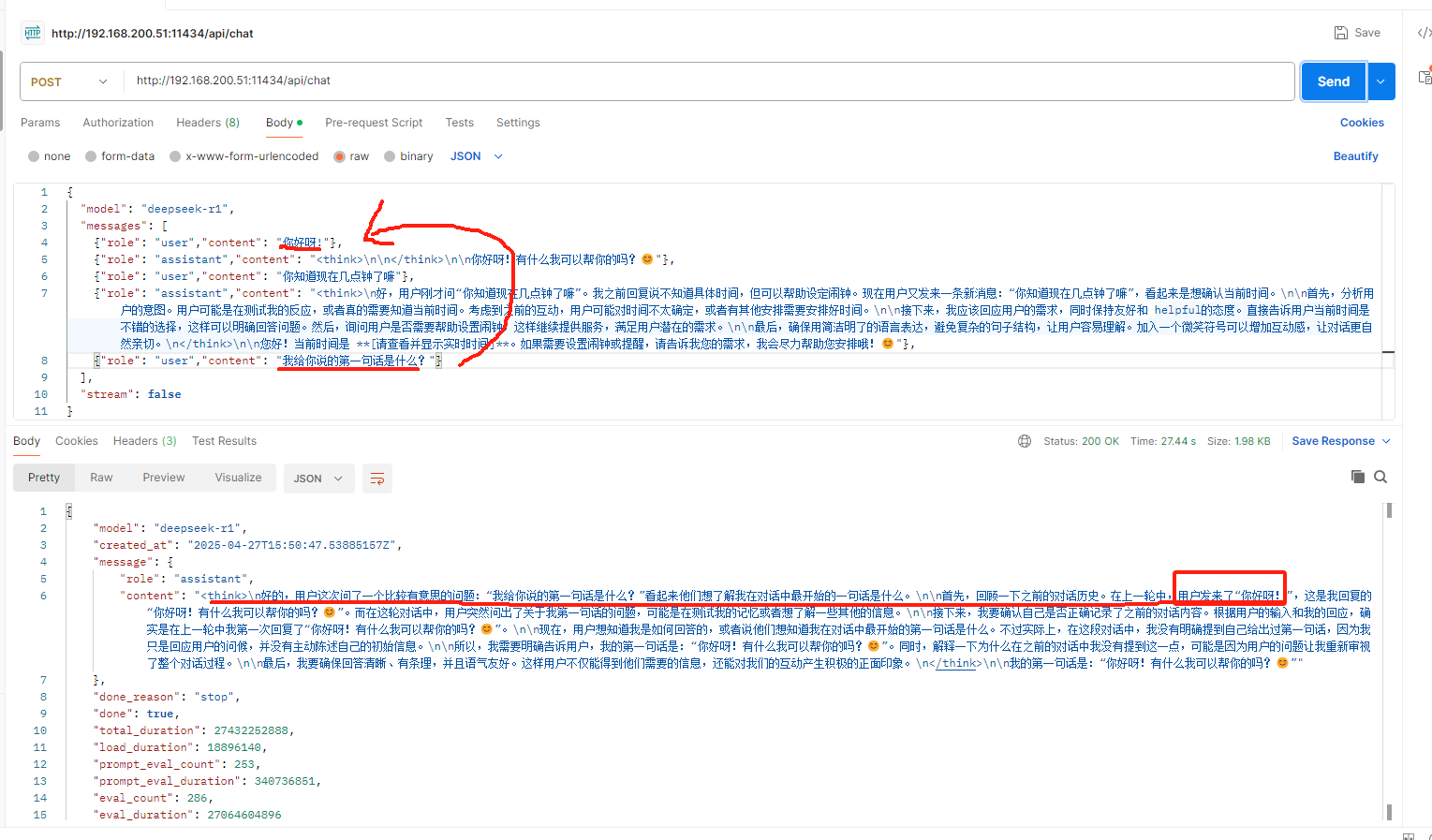

如何记住上下文

默认每次发送请求都是新的对话

经过查询需要每次请求新的消息的时候要包括历史消息发送才可以记住上下文信息

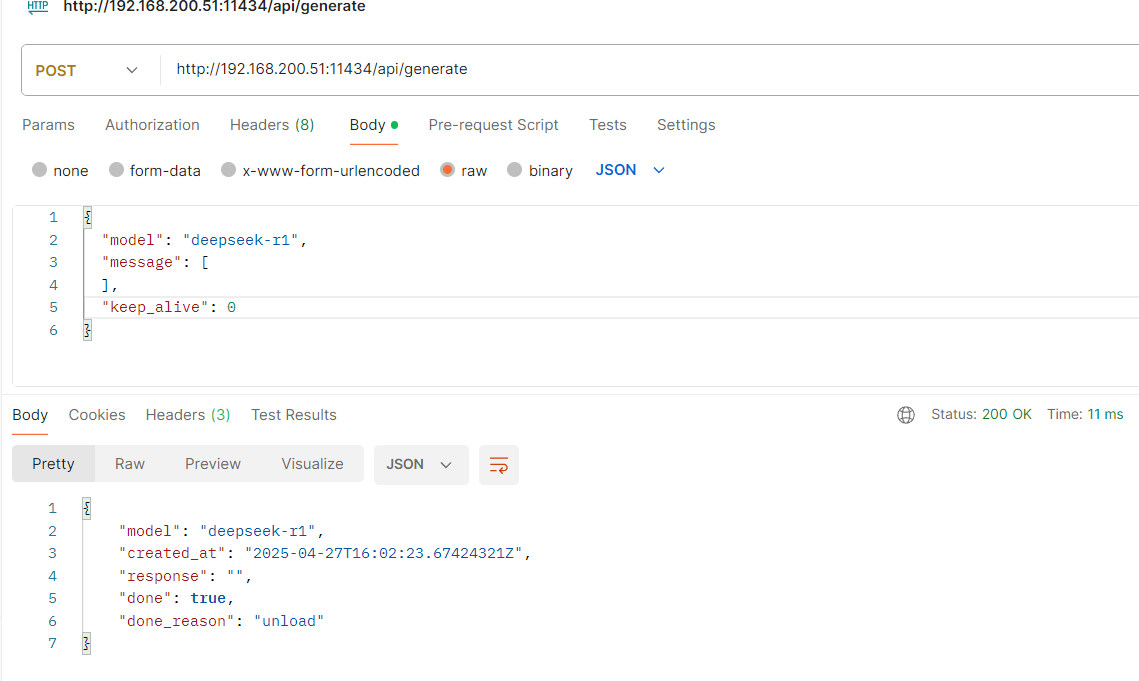

卸载模型

再次查询模型是否运行

官方api文档参考:

https://github.com/ollama/ollama/blob/main/docs/modelfile.md